3D场景渲染的视觉显著性驱动间接光照复用算法

时间:2023-02-26 11:50:06 来源:千叶帆 本文已影响人

齐淑杰,陈纯毅,胡小娟,于海洋

3D场景渲染的视觉显著性驱动间接光照复用算法

齐淑杰,陈纯毅*,胡小娟,于海洋

(长春理工大学 计算机科学技术学院,长春 130022)(∗通信作者电子邮箱chenchunyi@hotmail.com)

为提高路径追踪渲染3D场景的速度,提出3D场景渲染的视觉显著性驱动间接光照复用算法。首先,根据视觉感知中感兴趣区域显著性高、其他区域显著性低的特点得到场景画面的2D显著性图,该显著性图由图像的颜色信息、边缘信息、深度信息以及运动信息构成。然后,重新渲染高显著性区域的间接光照,而低显著性区域则在满足一定条件的情况下复用上一帧的间接光照,达到加速渲染的目的。实验结果表明:该算法生成画面的全局光照效果真实,在多个实验场景下的渲染速度均有提升,速度最高能达到高质量渲染的5.89倍。

路径追踪;

间接光照;

视觉感知;

显著性图;

加速渲染

路径追踪是一种模拟光照且能生成高真实感图像的渲染算法,目前已经广泛应用到电影、动画等领域。但是由于路径追踪算法需要从视点发射大量的光线,并且递归地追踪每一条光线,耗时庞大,故处理速度很低,难以应用于场景的快速绘制。

为了提升路径追踪绘制速率,一些基于层次包围盒(Bounding Volume Hierarchies)[1]、二叉空间分割树(Binary Space Partitioning Trees)[2]、八叉树(Octrees)[3]、KD树[4]和场景图[5]的方法被提出,用来减少光线与空间物体的求交时间。这些方法降低了空间结构对于光线追踪算法的影响,既能保证渲染效果,也可以减少绘制时间。为了进一步提高绘制速率,Stokes等[6]提出来一种基于光照分量的感知度量方法。通过场景中的不同反射材质特性,预测该材质在间接光照中的重要性,从而减少对重要性较低的材质的资源分配。可是实际应用当中,如果因为反射成分较少而忽略,那么会明显影响场景的真实性。因此,既想实现逼真的渲染效果,又要达到较高的绘制速率非常困难。

为了提升绘制速率且实现逼真的渲染效果,本文提出3D场景渲染的视觉显著性驱动间接光照复用算法。首先构造一种显著性度量模型,该模型通过对颜色、边缘、深度以及运动的量化,描述了人眼对于场景中事物的感知重要性;

其次在计算间接光照时,对属于显著性较高区域的像素重新发射光线计算间接光照,而属于显著性较低区域的像素则考虑是否可以复用可视场景点在上一帧的间接光照值,从而减少不必要的资源投入,达到加速的目的。

使用视觉感知原理来驱动三维场景绘制的基本思想是从人眼对于亮度、对比度的感知出发,得到视觉灵敏度模型。Meyer等[7]基于人类视觉系统较差的色彩空间灵敏度开发了自适应图像合成算法;

Ramasubramanian等[8]提出了高背景照明水平、高空间频率和高对比度水平视觉灵敏度的阈值模型,通过模拟亮度和对比度对于视觉感知灵敏度的影响来分配资源,但是这种方法没有包含方向信息;

Drettakis等[9]考虑了人眼对于遮挡和阴影所生成掩蔽的感知特性,减少对细节感知能力较差区域的资源投入,算法主要是对空间遮蔽的计算和优化,没有融合重要的颜色特征。以上方法是基于亮度和对比度的视觉模型,但真实的三维场景对于人的关注度的影响,受限于多种因素;

并且当图像的亮度、对比度不明显时,算法并不会得到加速效果。

Koch等[10]最早提出了有关视觉注意机制的计算模型,通过特征图加权得到显著性图,关注度高的区域显著性较高,反之显著性较低;

Lavoué等[11]研究形状、相机位置、材质和光照对视觉注意的影响生成3D网格的显著性模型;

Sundstedt等[12]将自下而上的视觉注意模型融合进渲染算法,提出了重要性模型;

Longhurst等[13]将物体的移动信息及物体的存在时间融合进重要度模型;

Meng等[14]通过中心渲染与眼动跟踪相结合,模拟了光感受器在人类视网膜中的分布,减少对人眼不易感知细节的计算。以上几种方法都根据显著性的高低来发射不同数量的光线,从而加速渲染;

但是由于显著性的实时变化,会造成帧数发生断断续续的变化,除此之外,由于低显著性区域发射了少量的光线,还会生成噪点。

综合上述方法的优点和缺点,本文提出了3D场景渲染的视觉显著性驱动间接光照复用算法。

2.1 算法步骤

本文的间接光照复用算法基于路径追踪框架,利用GPU渲染全局光照下的3D场景。算法主要分为:①根据空间信息计算出视觉显著性图(步骤1~3);

②通过显著性图,对显著性高的区域重新计算间接光照,对显著性低的区域则考虑复用上一帧的间接光照(步骤4);

③将间接光照与直接光照相加得到全局光照(步骤5)。本文算法框架如图1所示,详细步骤如下:

步骤1 每个像素点预先向场景发射一条光线,得到每个像素对应可视场景点的空间位置、空间法线、移动的物体及其阴影、直接光照存储在buffer中。

步骤2 通过空间位置计算出深度显著性图,通过法线计算出边缘显著性图,通过移动的物体及其阴影计算出移动显著性图,使用上一帧的颜色图计算出颜色显著性图。将以上四种显著性图相加得到第帧显著性图。

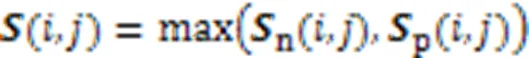

步骤3 将第帧显著性图与第-1帧显著性图取二者最大值融合得到综合显著性图。

步骤4 得到上一帧显著性图后,对于每一个像素,如果像素的显著性较低,则在上一帧中寻找与像素空间位置与法线夹角等条件近似的像素:如果存在这样的像素,像素就复用像素的间接光照;

但当像素A的显著性较高或者找不到近似的像素,则像素重新发射条光线进行路径追踪,重新计算间接光照值(为每个像素发射的光线数量)。

步骤5 将直接光照与间接光照相加得到本帧的全局光照。

图1 本文算法框架

2.2 显著性图的构建

本文的显著性图由四部分组成,分别是:颜色、边缘(指物体的边缘)、深度(指每个物体与视点的距离)、移动物体及其阴影(指场景中移动的物体以及移动的物体所生成的阴影)。本文显著性图是在每一帧开始绘制前计算出来的,用来指导本帧的绘制。

2.2.1颜色空间显著性

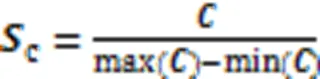

图2 颜色显著性图示例

2.2.2法线夹角计算空间边缘信息

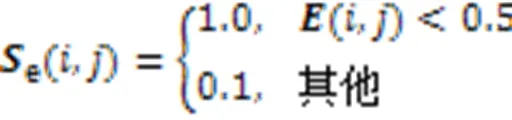

由于物体的边缘容易引起人眼的注意,而且物体的边缘容纳噪声的强度较弱,所以,将物体的边缘也作为显著性检测的指标之一。Canny边缘检测[16]和SUSAN算法[17]都是非常经典的边缘检测算法,但是使用这些算法在计算颜色交融的边缘时,无法得到非常精确的效果,而且速度较慢。因此,本文使用基于法线计算物体边缘的算法,通过计算当前像素与其周围的像素的法线夹角来确定这个像素点所对应的空间位置是不是边缘。

得到边缘显著性图后,发现图像中有些区域的边缘比较密集。密集边缘具有较高的空间频率,而人眼对于空间频率的感知,只有在2~4 cpd(cycles per degree)时才比较敏感[18],所以密集边缘容纳噪声的能力较强。cpd的值与图像的大小、距离图像的距离和观看图像的角度有关,所以本文生成了一个具有普适性的模型,提出一种简单快速的方法来减小密集边缘的显著性。处理边缘的详细步骤如下:

步骤2 将边缘图使用双线性插值方法下采样到原图像1/4大小,执行下一步。

步骤3 将下采样的图像使用最近邻插值上采样得到原图像大小,执行下一步。

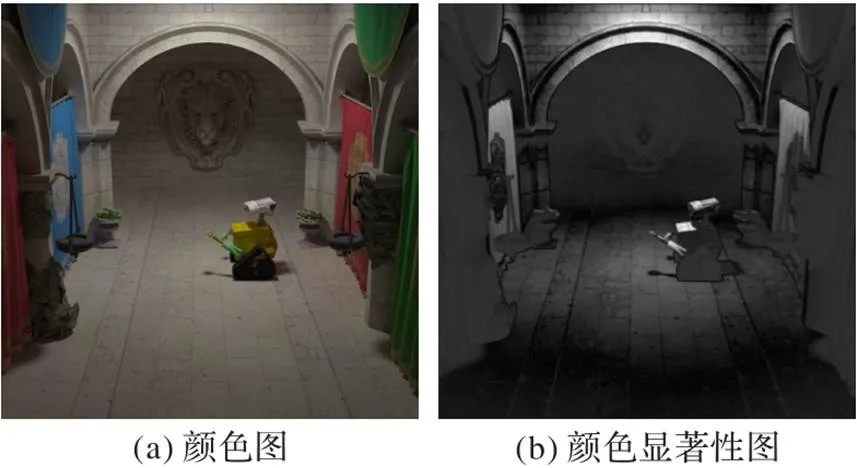

步骤5 最后将边缘图中每一个像素使用

图3(a)为边缘图,图3(b)为对密集区域的边缘处理后的边缘显著性图像。可以看出,边缘密集区域的显著性都降低了,而边缘稀疏区域的显著性很高。

图3 边缘显著性图示例

2.2.3相对深度得到深度显著性

离人眼近的物体由于接近而变得突出。距离在本文的模型中很容易计算,它只是一个物体到视点的距离。为了适应多种不同的场景,使用

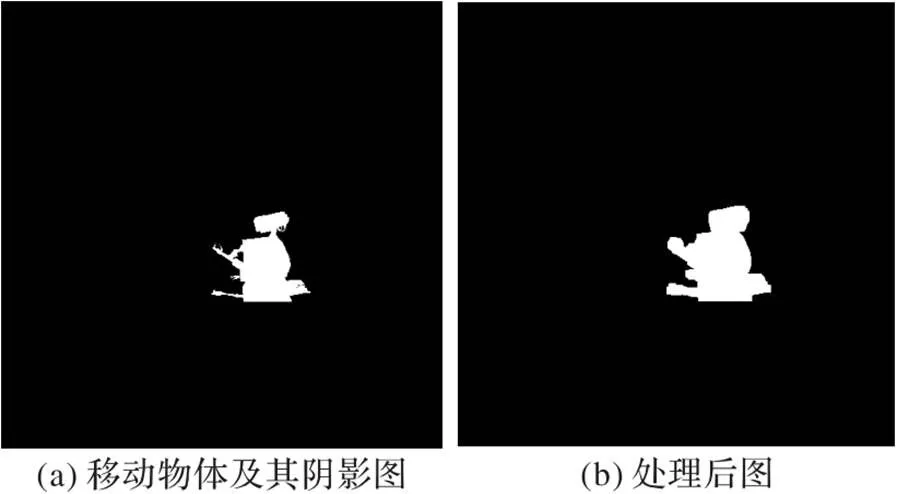

2.2.4移动的物体及其阴影

人眼对于移动的物体注意力比较高,所以本文将移动的物体作为显著性的一部分;

同时也考虑移动物体的阴影,因为阴影的位置和法线寄托于呈现阴影的平面上。如果阴影发生了移动,仅仅根据法线和空间位置无法判断这一像素是否要重新计算间接光照,所以将移动物体的阴影也作为显著性图的一部分。

图4 移动成分显著性图

本文单独计算每一种显著性,为了尽可能地使每一个像素点的显著性大,所以将四种显著成分相加,使用

2.3 间接光照的复用

在间接光照的复用过程中,需要考虑以下的四种情况:

1)根据显著性复用间接光照;

2)根据空间位置法线方向复用间接光照;

3)光照分量;

4)随机复用间接光照。

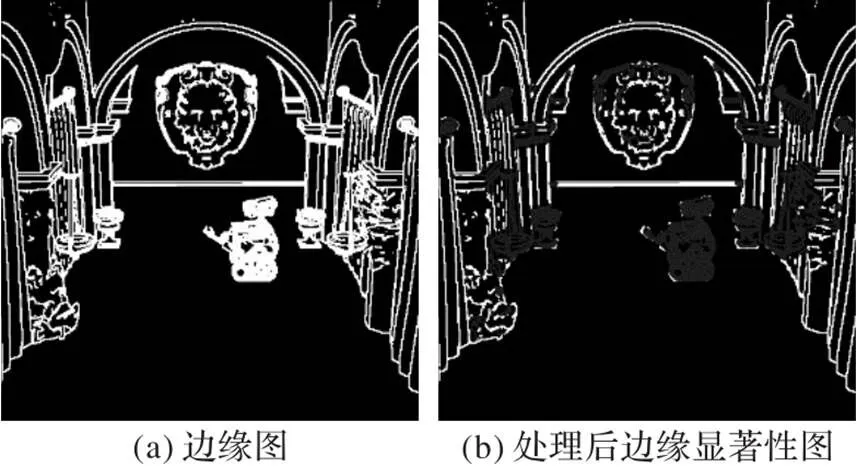

2.3.1根据显著性复用间接光照

在间接光照的复用过程中,首先考虑的是像素点的显著性,如果此像素点不显著,就考虑对这个像素点进行间接光照的复用。

图5 显著性图

2.3.2根据空间位置法线方向复用间接光照

在满足了显著性较低的条件之后,考虑第二个条件:空间位置以及法线方向。

在找到了满足了这三个条件之后的像素后,则像素可以考虑复用像素的间接光照值。

2.3.3光照分量

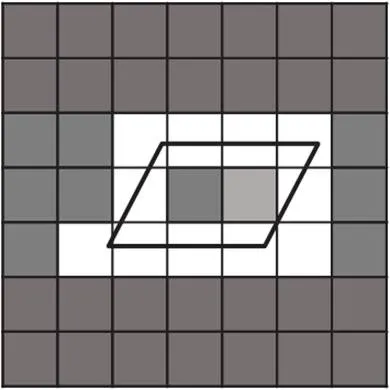

在满足了以上的两个条件后,已经找到在上一帧中位置及法线符合条件的像素,计算第三种情况:像素间接光照相对于像素直接光照的重要性。图7(a)为上一帧的间接光照图,图7(b)本帧的直接光照图。为了描述间接光照在这个像素点的重要性,使用

计算,当的时候,说明间接光照重要性较低,才会复用间接光照。其中:Pr、Pg、Pb分别为C像素间接光照的r、g、b分量与A像素直接光照的r、g、b分量之比。这个判断条件描述了只有在这一像素间接光照不够重要的情况下才会复用间接光照。

图7 光照分量图

2.3.4随机复用间接光照

间接光照的复用大幅减少了计算时间,使渲染速度明显提高。可是在实验过程中发现,对于像素中的某一点,长时间复用上一帧的间接光照,有可能会出现噪点,原因是空间位置的渐变、法线方向的渐变或者光源的渐变。

为解决这个问题,本文提出随机复用间接光照的算法。在计算像素点的间接光照时,首先执行一次俄罗斯轮盘赌。当计算的随机数<0.98时,就考虑对此像素点进行间接光照的复用,也就是对于2%的像素点重新计算间接光照。本文随机数取值0.98是经过多次实验得到的优质常数。

在基于GPU的optix渲染器中实现了本文算法,并通过该渲染器来进行对比实验。实验中所有算法都在Intel Core i5-8500 CPU @3.00 GHz和NVIDIA GeForce GTX 1060 3 GB的环境下运行。其中NVIDIA GeForce GTX 1060 3 GB有1 152个CUDA个核心。实验使用路径追踪算法进行绘制,将本文算法、高质量渲染算法和文献[14]算法绘制的图像分辨率设为512×512像素。

3.1 显著性图的实现

本文通过对颜色、边缘、深度、移动物体及其阴影的分析计算得到显著性图,如图8所示。其中:图(a)为颜色显著性,通过上一帧的颜色图像计算得到,其他的显著性成分是本帧计算得到,三个场景分别计算得到了准确的显著性;

图(b)为边缘显著性,使用本文算法之后,减小了密集边缘的显著性,稀疏边缘仍有很高的显著性;

图(c)为深度显著性图,可以看到位于距离人眼较近的物体的显著性较高,位于距离人眼较远的物体显著性较低;

图(d)为移动的物体及其阴影,通过对移动物体的3D模型的光线相交计算,对光线与移动物体及其阴影相交的像素赋予较高的显著性,可以看出移动物体和移动物体的阴影的显著性较高,得到了准确的移动显著性图。最后将多种显著性成分融合得到图(e)的显著性图。

图8 显著性结构图

3.2 绘制效果

为了比较算法的绘制效果,分别渲染了静态场景(场景一)、存在移动物体的场景(场景二)和移动视点的场景(场景三)。如图9所示图像为每个像素追踪1 024条光线的绘制效果。在下文的主观实验与客观实验中,为了进行比较,分别为每个像素追踪16、64、256、1 024条光线。

图9 绘制效果图

3.2.1主观实验

将投票结果除以投票次数得到了实验参与者对场景一、场景二、场景三所生成图像的投票百分比结果。三个场景的投票结果均分布在50%附近,说明有50%的参与者正确地指出了高质量的结果,那么从统计学上来说,对于这两个图像,观察者正确识别图像百分比为50%,也就是已经无法区分本文算法与高质量渲染算法的绘制效果。因此,本文算法生成了准确的效果。

3.2.2客观实验

由表1可知:场景一中,本文算法的绘制效果略优于文献[14]的算法,这是由于静态场景中的影响因素较少,比较容易达到接近高质量渲染的绘制效果;

而在场景二和场景三中,随着物体的移动、视点的移动,影响绘制效果的因素较多,想达到高质量渲染的绘制效果比较困难,可以看到本文算法与文献[14]的算法存在明显的绘制差异,本文算法远远优于文献[14]算法的绘制效果。本文算法的SSIM指标也要高于文献[14]算法,且本文算法绘制效果在SSIM的评价指标中均超过0.989。这说明本文算法更加接近原始图像,而且还取得了非常好的效果。

表1 质量评价结果

3.3 绘制速率

在三个场景中进行绘制速率的对比实验,每个像素发射1 024条光线,各绘制50帧,取平均每帧的绘制时间,结果见表2。通过三组实验可以看出:本文算法构造显著性图的时间在10 ms之内,其速度要快于文献[14]算法;

通过绘制时间的对比,发现本文算法的速度可以达到高质量渲染算法的3~6倍,文献[14]算法的2~3倍。

表2 绘制50帧的平均每帧绘制时间

每个像素分别发射16、64、256、1 024条光线时,本文算法相较于高质量渲染算法速率的提升倍数如表3所示。可以看出,在发射四种不同光线条数的情况下,本文的绘制速率均有提高,但在发射的光线数量较少时,提升幅度较小。这是由于本文算法在发射光线之前,先发射了一条光线来得到场景的空间信息,相当于多发射了1条光线,造成加速效果不显著,但是当发射光线较多时,可以忽略这条光线,从而得到显著的加速效果。

表3 本文算法相比高质量渲染算法速率的提升倍数

综上所述,在图像质量方面:文献[14]算法的生成图像看起来较为粗糙,本文算法则生成了与高质量渲染无法区分的效果;

在绘制速率方面:将本文算法与高质量渲染算法在三种不同场景、不同光线数量的情况下进行了绘制速率的比较,本文算法的速率也明显更优。本文算法生成效果逼真,绘制效果和绘制速度均优于对比算法。

本文提出的3D场景渲染的视觉显著性驱动间接光照复用算法从人眼视觉感知的特点出发,通过将颜色、边缘、深度、移动物体及阴影的感知结果融合得到显著性图,通过显著性图指导渲染,显著性较高的区域重新计算间接光照,显著低的像素可以考虑复用上一帧的间接光照。将本文算法与高质量渲染算法、文献[14]算法进行比较,通过主观与客观的图像质量评判,可知本文算法可以生成真实的效果;

且同样条件下本文算法的绘制时间更短,速度最高能达到高质量渲染算法的5.89倍。本文算法有效减少了渲染时间,减少了不必要资源的投入,在漫反射场景能得到非常好的效果。

尽管本文算法能够有效实现快速渲染,但依旧存在改进空间:1)本文对多种影响感知因素进行计算,所以在构造显著性图时会消耗一定的时间,从而影响渲染的速度,今后的工作中可以考虑使用更简单且快速的方法来计算显著性。2)本文主要针对的是漫反射场景,在以后的工作中,希望加入有镜面反射、折射的场景。

[1] HENDRICH J, MEISTER D, BITTNER J. Parallel BVH construction using progressive hierarchical refinement[J]. Computer Graphics Forum, 2017, 36(2):

487-494.

[2] CHEN Z Q, TAGLIASACCHI A, ZHANG H. BSP‑Net:

generating compact meshes via binary space partitioning[C]// Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway:

IEEE, 2020:42-51.

[3] 张文胜,解骞,钟瑾,等. 基于八叉树邻域分析的光线跟踪加速算法[J]. 图学学报, 2015, 36(3):

339-344.(ZHANG W S, XIE Q, ZHONG J, et al. Acceleration algorithm in ray tracing by the Octree neighbor finding[J]. Journal of Graphics, 2015, 36(3):

339-344.)

[4] ZHANG J, GUO H Q, HONG F, et al. Dynamic load balancing based on constrained K‑D tree decomposition for parallel particle tracing[J]. IEEE Transactions on Visualization and Computer Graphics, 2018, 24(1):

954-963.

[5] CHEN T S, YU W H, CHEN R Q, et al. Knowledge‑embedded routing network for scene graph generation[C]// Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway:

IEEE, 2019:

6156-6164.

[6] STOKES W A, FERWERDA J A, WALTER B, et al. Perceptual illumination components [J]. ACM Transactions on Graphics, 2004, 23(3):

742.

[7] MEYER G W, LIU A H. Color spatial acuity control of a screen subdivision image synthesis algorithm[C]// Proceedings of the SPIE 1666, Human Vision, Visual Processing, and Digital Display III. Bellingham, WA:

SPIE, 1992:

No.135984.

[8] RAMASUBRAMANIAN M, PATTANAIK S N, GREENBERG D P. A perceptually based physical error metric for realistic image synthesis[C]// Proceedings of the 26th Annual Conference on Computer Graphics and Interactive Techniques. New York:

ACM, 1999:73-82.

[9] DRETTAKIS G, BONNEEL N, DACHSBACHER C, et al. An interactive perceptual rendering pipeline using contrast and spatial masking[C]// Proceedings of the 18th Eurographics Symposium on Rendering Techniques. Goslar:

Eurographics Association, 2007:297-308.

[10] KOCH C, ULLMAN S. Shifts in selective visual attention:

towards the underlying neural circuitry[J]. Human Neurobiology, 1985, 4(4):

219-227.

[11] LAVOUÉ G, CORDIER F, SEO H, et al. Visual attention for rendered 3D shapes[J]. Computer Graphics Forum, 2018, 37(2):

191-203.

[12] SUNDSTEDT V, DEBATTISTA K, LONGHURST P, et al. Visual attention for efficient high‑fidelity graphics[C]// Proceedings of the 21st Spring Conference on Computer Graphics. New York:

ACM, 2005:169-175.

[13] LONGHURST P, DEBATTISTA K, CHALMERS A. A GPU based saliency map for high‑fidelity selective rendering[C]// Proceedings of the 4th International Conference on Computer Graphics, Virtual Reality, Visualisation and Interaction in Africa. New York:

ACM, 2006:21-29.

[14] MENG X X, DU R F, ZWICKER M, et al. Kernel foveated rendering[J]. Proceedings of the ACM on Computer Graphics and Interactive Techniques, 2018, 1(1):

No.5.

[15] MCANDREW A. Principles of digital image processing:

fundamental techniques[J]. Computing Reviews, 2010, 51(7):

411-412.

[16] GAURAV K, GHANEKAR U. Image steganography based on Canny edge detection, dilation operator and hybrid coding[J]. Journal of Information Security and Applications, 2018, 41:

41-51.

[17] XU L M, LV J D. Recognition method for apple fruit based on SUSAN and PCNN[J]. Multimedia Tools and Applications, 2018, 77(6):

7205-7219.

[18] SCHWARTZ N. Face perception enhances the detection of spatial frequencies between 2-4 cycles per degree (16-32 cycles per face)[J]. Journal of Vision, 2009, 9(8):

No.537.

Visual‑saliency‑driven reuse algorithm of indirect lighting in 3D scene rendering

QI Shujie, CHEN Chunyi*, HU Xiaojuan, YU Haiyang

(,,130022,)

In order to accelerate rendering of 3D scenes by path tracing, a visual‑saliency‑driven reuse algorithm of indirect lighting in 3D scene rendering was proposed. Firstly, according to the characteristics of visual perception that the regions of interest have high saliency, while other regions have low saliency, a 2D saliency map of the scene image was obtained, which consists of color information, edge information, depth information and motion information of the image. Then, the indirect lighting in the high‑saliency area was re‑rendered, while the indirect lighting of the previous frame was reused in the low‑saliency area under certain conditions, thereby accelerating the rendering. Experimental results show that the global lighting effect of the image generated by this method is real, and the rendering speed of the method is improved in several experimental scenes, and the speed can reach up to 5.89 times of that of the high‑quality rendering.

path tracing; indirect lighting; visual perception; saliency map; accelerated rendering

This work is partially supported by National Natural Science Foundation of China (U19A2063), Science and Technology Development Program of Jilin Province (20180519012JH, 20190302113GX), Science and Technology Research Project of Education Department of Jilin Province during “the 13th Five‑Year Plan” (JJKH20200792KJ, JJKH20200799KJ).

QI Shujie, born in 1996, M. S. candidate. His research interests include realistic 3D graphic drawing.

CHEN Chunyi, born in 1981, Ph. D., professor. His research interests include photorealistic 3D graphic drawing, computer simulation.

HU Xiaojuan, born in 1985, Ph. D., lecturer. Her research interests include machine learning, virtual reality.

YU Haiyang, born in 1989, Ph. D., lecturer. His research interests include intelligent information processing.

TP391.41

A

1001-9081(2022)11-3551-07

10.11772/j.issn.1001-9081.2021122181

2021⁃12⁃24;

2022⁃03⁃14;

2022⁃05⁃16。

国家自然科学基金资助项目(U19A2063);

吉林省科技发展计划项目(20180519012JH, 20190302113GX);

吉林省教育厅“十三五”科学技术研究项目(JJKH20200792KJ, JJKH20200799KJ)。

齐淑杰(1996—),男,山东滨州人,硕士研究生,主要研究方向:真实感三维图形绘制;

陈纯毅(1981—),男,重庆人,教授,博士,CCF会员,主要研究方向:真实感三维图形绘制、计算机仿真;

胡小娟(1985—),女,山东淄博人,讲师,博士,CCF会员,主要研究方向:机器学习、虚拟现实;

于海洋(1989—),男,吉林长春人,讲师,博士,主要研究方向:智能信息处理。